6月9日消息,Hugging Face現已公布 4.5 億參數開源機器人模型 SmolVLA,該模型主打高普適性,可在 MacBook Pro等的消費級硬件設備上運行,旨在幫助開發者降低入門成本。

當下,業界機器人模型通常采用“視覺 - 語言 - 行動 ”(Vision-Language-Action,VLA)設計,此類模型嘗試在單一架構中整合感知能力、語言理解與行動決策,從而讓機器人實現自主執行復雜任務。不過相應模型訓練成本極高,目前大多數模型仍為閉源項目,訓練過程中依賴昂貴硬件、大量工程資源和大規模私有數據集。

為此,Hugging Face 推出 SmolVLA 這一輕量級開源模型,使用公開數據集進行訓練,并可在消費級硬件設備上運行,旨在降低愛好者入門成本,推動通用機器人智能體的研究進展。

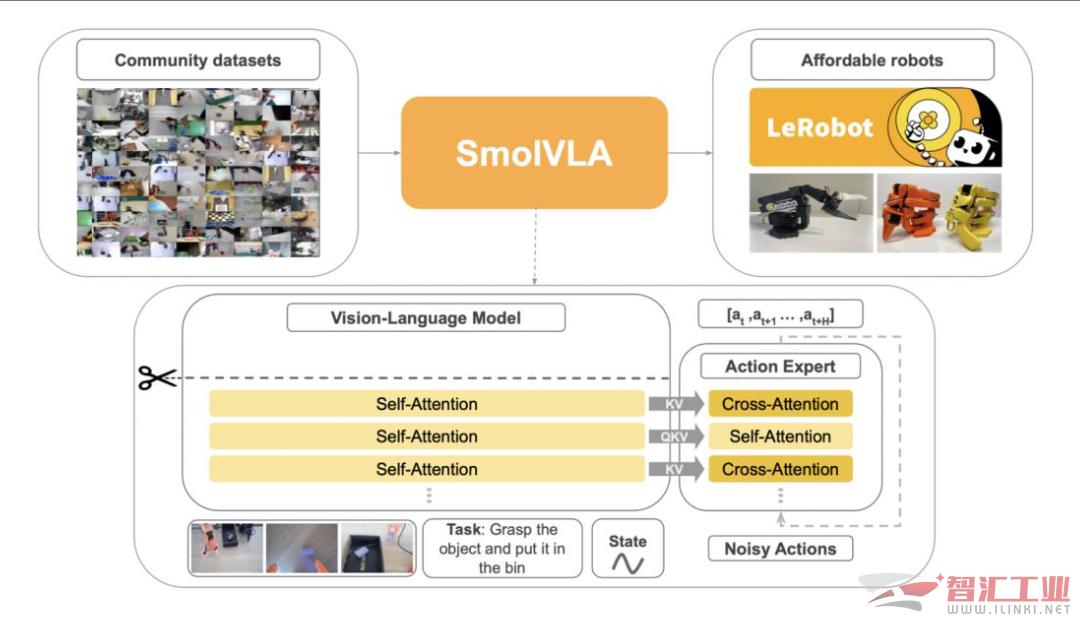

據介紹,SmolVLA在模型架構上結合Transformer結構與flow-matching解碼器,并采用了四項關鍵優化技術:一是跳過視覺模型中一半層數,以提升推理速度并減小模型體積;二是交替融合自注意力與交叉注意力模塊,提高多模態信息整合效率;三是減少視覺Token數量以提升處理效率;四是采用更輕量的SmolVLM2作為視覺編碼器,從而進一步降低硬件要求。

圖源:Hugging Face(下同)

而在訓練策略方面,SmolVLA首先通過通用操作數據進行預訓練,再針對特定任務進行微調,以提升適應能力。因此雖然SmolVLA的訓練數據遠少于現有其他VLA模型(僅包括不到3萬個任務記錄),但Hugging Face表示,該模型在模擬環境和真實場景中的表現與大型模型相當,甚至在部分任務上實現“超越”。

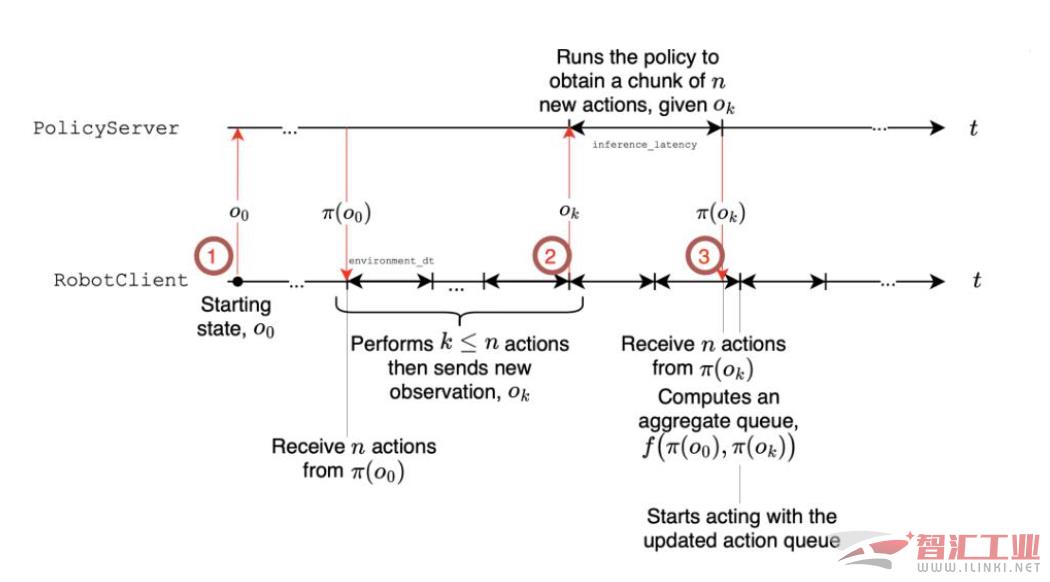

此外,Hugging Face透露SmolVLA還引入“異步推理架構(Asynchronous Inference Stack),將感知處理(如視覺和語音理解)與動作執行進行解耦,使機器人在面對快速變化的環境時能做出更及時的響應,大幅提升其實用性。

Hugging Face強調,用戶使用MacBook Pro筆記本電腦等消費級硬件即可運行SmolVLA-450M 模型,無需花費大成本采購專用AI訓練服務器。同時用戶也可以考慮采購 Hugging Face推出的低成本機器人平臺(SO-100、SO-101 和 LeKiwi)等降低成本。

Hugging Face援引自家進行的多項基準測試驗證SmolVLA的性能,在LIBERO與Meta-World 等模擬測試平臺上,SmolVLA的表現據稱優于Octo、OpenVLA等業界競品,而在使用真實機器人 SO-100 和 SO-101 進行抓取、放置、堆疊與分類任務中,SmolVLA 也展現出更好的性能。

目前,SmolVLA的基礎模型已在Hugging Face平臺上線,完整訓練方法也同步在GitHub上公開。

(審核編輯: 光光)

分享